Deep Neural Networks

- Neural networks that have more than two hidden layers (2개 이상)

- Capacity increases when the number of hidden layers is large

-> Capa을 올리기 위해서 더 많은 connections이 필요함

복잡한 모델을 사용하기 위해서는?

- Wide (width) → 한번에 복잡한 것 처리

- Deep (depth) → 여러 층을 거치며 복잡한 것을 처리

- Wide Networks:

- 'Wide' 신경망은 주로 네트워크의 각 층에 많은 수의 뉴런(또는 노드)를 가집니다.

- 이러한 구조는 넓은 데이터(많은 특징을 가진 데이터)를 처리하는데 적합할 수 있습니다.

- 'Wide' 네트워크는 종종 특징 간의 복잡한 상호작용을 모델링하는 데 유용하지만, 때로는 과적합(overfitting)의 문제가 발생할 수 있습니다. → 한번에 복잡한 것 처리

- Deep Networks:

- 'Deep' 신경망은 여러 층(layer)을 가지며, 각 층은 일반적으로 비교적 적은 수의 뉴런을 포함합니다.

- 이러한 구조는 복잡한 문제를 해결하는 데 유용하며, 데이터에서 고차원의 패턴과 구조를 학습할 수 있습니다.

- 'Deep' 신경망은 보다 복잡한 추상화를 수행할 수 있지만, 학습이 더 어렵고 계산 비용이 더 많이 들 수 있습니다.

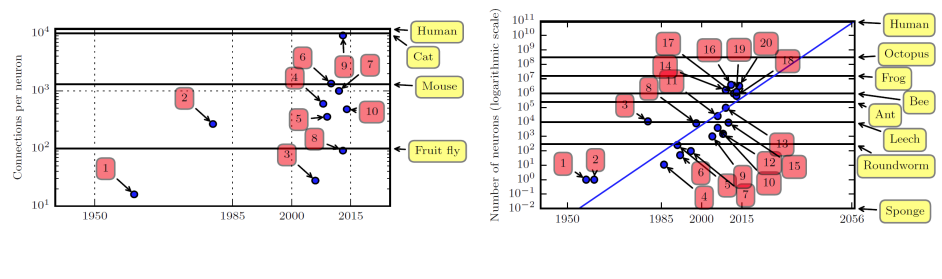

왜 딥 뉴럴 네트워크(Deep Neural Networks)가 현재 매우 중요하고 주목받는 기술이 되었는가?

- 계산 능력의 증가:

- 더 많은 가중치(Weights)와 높은 계산 비용: 딥 뉴럴 네트워크는 수많은 가중치를 포함하고 있으며, 이들을 학습시키는데 상당한 계산 능력이 필요합니다.

- GPU의 활용: GPU(그래픽 처리 장치)의 발전과 그 활용은 딥 러닝 모델 학습에 큰 돌파구가 되었습니다. GPU는 병렬 처리 능력이 뛰어나 대량의 데이터와 복잡한 네트워크를 효율적으로 학습시킬 수 있게 해줍니다. (컴퓨터 성능)

- 데이터 양의 증가:

- 데이터의 범람: 현재 데이터는 곳곳에서 대량으로 생성되고 있으며, 이러한 데이터는 딥 뉴럴 네트워크 학습에 필수적인 자원입니다.

- 필요한 기술의 양 감소: 데이터 사이언스와 딥 러닝 기술이 점점 접근하기 쉬워지고 있습니다. 이에 따라 데이터를 처리하고 학습하는데 필요한 기술적 장벽이 낮아지고 있습니다.

- 허용 가능한 성능과 인간의 성능 초과: 적정 수준의 성능을 달성하기 위해서는 카테고리별로 약 5,000개의 레이블이 붙은 학습 데이터가 필요할 수 있으며, 인간의 성능을 뛰어넘기 위해서는 1000만 개의 레이블이 붙은 데이터가 필요할 수 있습니다. 이는 딥 뉴럴 네트워크가 많은 데이터를 기반으로 더욱 강력한 성능을 발휘할 수 있음을 의미합니다.

이러한 요인들은 딥 뉴럴 네트워크가 오늘날 매우 강력한 도구로 부상하는 데 결정적인 역할을 했습니다. 컴퓨터의 계산 능력과 방대한 양의 데이터가 결합되어, 이전에는 불가능했던 수준의 복잡한 문제 해결이 가능해졌습니다.

Critical Issue 1: Vanishing Gradient ▪ Gradient converges to zero in deep network

"Vanishing Gradient" (사라지는 기울기) 문제는 딥 뉴럴 네트워크(DNN)에서 자주 발생하는 중요한 이슈 중 하나입니다. 이 문제는 신경망이 깊어질수록 학습 과정에서 기울기(gradient)가 점점 줄어들어 결국 거의 0에 수렴하는 현상을 의미합니다. 이로 인해 네트워크의 가중치가 효과적으로 업데이트되지 않아 학습이 제대로 이루어지지 않는 문제가 발생합니다.

Vanishing Gradient의 원인과 영향:

- 역전파 과정 중 기울기 감소: 딥 뉴럴 네트워크에서는 오류(error)를 출력층에서 입력층 방향으로 역전파(backpropagate)하며 가중치를 업데이트합니다. 네트워크가 깊어질수록 기울기가 점차 작아지는 현상이 발생할 수 있으며, 특히 활성화 함수로 시그모이드나 탄젠트 같은 함수를 사용할 경우 이러한 문제가 더 심해집니다.

- 학습 속도 저하: 기울기가 사라지면 네트워크의 초기 층에 있는 가중치들이 충분히 업데이트되지 않아 학습 속도가 크게 느려집니다.

- 모델의 성능 저하: 가중치 업데이트가 제대로 이루어지지 않으면 모델의 성능도 저하됩니다. 특히 네트워크의 초기 층에서 학습이 잘 이루어지지 않을 경우, 복잡한 특징을 추출하는 데 어려움을 겪을 수 있습니다.

Vanishing Gradient 해결 방법:

- ReLU 활성화 함수 사용: ReLU(Rectified Linear Unit) 활성화 함수는 음수 입력에 대해 0을 반환하고, 양수 입력에 대해서는 입력 값을 그대로 반환합니다. 이는 기울기가 쉽게 사라지는 문제를 해결하는 데 도움이 됩니다.

- 네트워크 초기화 방법 개선: 적절한 가중치 초기화 방법을 사용하면, 학습 초기 단계에서 vanishing gradient 문제를 줄일 수 있습니다.

- 배치 정규화(Batch Normalization): 각 층의 출력을 정규화하여 기울기 소실 문제를 완화할 수 있습니다.

- Residual Connections(잔차 연결): 이는 입력을 네트워크의 더 깊은 층으로 직접 전달하여 기울기가 사라지는 문제를 감소시키는 방법입니다. ResNet과 같은 아키텍처에서 사용됩니다.

Vanishing Gradient 문제를 해결하는 것은 딥 뉴럴 네트워크를 효과적으로 학습시키는 데 매우 중요합니다.

"Vanishing Gradient" 문제의 첫 번째 해결책으로 "Pre-training (2006)"을 언급하셨습니다. 이 방법은 딥 뉴럴 네트워크의 초기 훈련 과정에서 매우 중요한 역할을 했으며, 특히 딥 빌리프 네트워크(Deep Belief Networks, DBN)와 제한된 볼츠만 머신(Restricted Boltzmann Machine, RBM)을 이용한 사전 훈련에 초점을 맞췄습니다. 이 접근 방식은 딥 러닝의 초기 단계에서 큰 발전을 가져왔지만, 몇 가지 단점도 존재합니다.

- Deep Belief Networks (DBN)와 RBM을 이용한 Pre-training:

- DBN: DBN은 여러 겹의 확률적, 비지도 학습 모델로, 각 층을 효과적으로 사전 훈련시키기 위해 사용됩니다. DBN은 복잡한 데이터 분포를 모델링할 수 있으며, 각 층의 가중치를 효율적으로 초기화하는 데 도움을 줍니다.

- RBM: RBM은 에너지 기반의 모델로, 두 계층 간의 연결을 통해 데이터를 재구성하는 데 사용됩니다. RBM을 이용한 사전 훈련은 각 층의 가중치를 초기화하여, 네트워크가 더 효과적으로 특징을 학습할 수 있게 해줍니다.

- Pre-training의 이점:

- 네트워크의 각 층이 데이터의 복잡한 특징을 잘 파악할 수 있도록 도와줍니다.

- 사전 훈련된 네트워크는 종종 더 빠르게 수렴하며, 성능이 개선될 수 있습니다.

- Vanishing Gradient 문제를 완화하는 데 도움을 줍니다.

- 단점:

- 계산 부담: Pre-training 과정은 계산적으로 매우 부담스럽고 시간이 많이 소요됩니다. 특히 큰 규모의 네트워크와 데이터셋에 대해 이 과정을 수행하는 것은 매우 비효율적일 수 있습니다.

- 복잡성 증가: 사전 훈련 절차는 모델의 복잡성을 증가시키며, 특히 최신 딥 러닝 아키텍처에서는 필요하지 않을 수 있습니다.

이러한 사전 훈련 방식은 딥 러닝의 초기 단계에서 매우 중요한 역할을 했지만, ReLU 활성화 함수, 초기화 방법, 배치 정규화 등과 같은 새로운 기법들이 개발되면서 그 중요성이 감소했습니다. 현대의 딥 러닝 모델은 이러한 최신 기술을 통해 사전 훈련 없이도 효과적으로 훈련될 수 있습니다.

"Vanishing Gradient" 문제의 두 번째 해결책인 "ReLU activation (2012)"에 대해 설명하겠습니다. ReLU (Rectified Linear Unit)는 신경망에서 널리 사용되는 활성화 함수입니다. 이 함수는 특히 딥 러닝 모델에서 Vanishing Gradient 문제를 완화하는 데 큰 도움을 줍니다.

ReLU 활성화 함수의 특징:

- 간단한 계산: ReLU 함수는 로 정의됩니다. 이는 입력이 양수일 경우 그 값을 그대로 출력하고, 음수일 경우 0을 출력합니다. 이러한 단순한 형태로 인해 계산이 매우 효율적입니다.

- 큰 기울기 유지: ReLU는 양수 입력에 대해 기울기가 1로 유지되기 때문에, 신경망이 깊어져도 기울기가 소실되는 문제를 상당 부분 해결합니다.

ReLU의 단점:

- Dead Neurons 문제: ReLU 함수의 가장 큰 단점 중 하나는 네트워크의 뉴런이 "죽을(deactivate)" 수 있다는 것입니다. 특히, 입력이 음수일 경우 ReLU는 항상 0을 출력하기 때문에, 해당 뉴런은 그 이후의 학습 과정에서 아무런 역할을 하지 못하게 됩니다. 이 현상은 "Dying ReLU"( Drawback: Deactivate for every nodes)문제라고 불리며, 이로 인해 해당 뉴런이 더 이상 가중치 업데이트에 참여하지 못하게 됩니다.

- 이 문제에 대한 해결책으로, Leaky ReLU나 Parametric ReLU와 같은 ReLU의 변형들이 제안되었습니다. 이러한 변형은 음수 입력에 대해 아주 작은 기울기를 부여하여 뉴런이 완전히 죽는 것을 방지합니다.

ReLU 활성화 함수의 도입은 심층 신경망의 효율적인 학습을 가능하게 하는 중요한 발전이었으며, Vanishing Gradient 문제를 완화하는 데 크게 기여했습니다.

Critical Issue 2: Overfitting

- 고용량 모델에서는 과적합이 발생할 수 있습니다.

- 과적합은 모델이 훈련 데이터에 지나치게 최적화되어 새로운 데이터에 대한 예측 성능이 떨어지는 현상을 말합니다. 이를 방지하기 위해 드롭아웃 규제와 규범 규제 같은 기술이 사용됩니다. 이러한 기술은 모델의 복잡성을 제한하고, 네트워크가 학습 데이터의 노이즈에 과도하게 반응하지 않도록 도와줍니다. 따라서 딥 뉴럴 네트워크의 일반화 능력을 향상시킬 수 있습니다.

해결책 1: 드롭아웃 규제

- 드롭아웃 기술: 훈련 과정에서 신경망의 일부 유닛(은닉층 및 보이는 층)을 임의로 비활성화합니다.

- 드롭아웃 비율: 일반적으로 은닉 유닛은 50%, 보이는 유닛은 20%입니다.

- 가중치 조정: 훈련 중 유닛이 확률 로 유지되면, 테스트 시 그 유닛의 나가는 가중치는 로 곱해져 네트워크 출력의 규모를 유지합니다.

- 훈련 후: 훈련이 끝난 후 예측을 할 때는 드롭아웃을 적용하지 않습니다.

해결책 2: 규범 규제

- 목표: 손실 함수에 규제 항을 추가하여 모델의 과대적합 가능성을 제한함으로써 큰 가중치에 대해 패널티를 부여합니다.

- 기술:

- 2-노름 패널티 (릿지 회귀, 티호노프 규제): 손실 함수에 가중치 제곱의 합에 해당하는 패널티를 추가합니다.

- 1-노름 패널티 (라쏘 회귀): 가중치 절대값의 합에 해당하는 패널티를 추가하여 모델 가중치의 희소성을 촉진합니다.

- 가중치 감소: 일반적으로 2-노름 패널티와 함께 사용되어 훈련 동안 점진적으로 가중치를 줄입니다.

람다와 모델의 오버핏 관점에서의 방향성 ★

람다(λ)는 정규화 기법에서 중요한 매개변수로, 모델의 오버피팅을 방지하는 데 사용됩니다. 정규화는 모델이 훈련 데이터에 과적합되는 것을 방지하기 위해 모델의 복잡성에 패널티를 부과하는 기술입니다. 람다는 이 패널티의 강도를 조절합니다.

람다의 역할:

- 패널티 강도 조절: 람다 값이 크면, 패널티가 증가하여 모델의 복잡성이 감소합니다. 이는 모델이 데이터의 노이즈나 불필요한 패턴에 덜 민감하게 반응하도록 만듭니다. 반대로 람다 값이 작으면 패널티가 줄어들어 모델이 데이터에 더 민감하게 반응할 수 있습니다.

- 오버피팅 방지: 람다 값을 적절히 설정하면 모델의 과적합을 방지하고 일반화 성능을 향상시킬 수 있습니다. 너무 높은 람다 값은 모델을 과소적합시킬 수 있으며, 너무 낮은 람다 값은 과적합을 유발할 수 있습니다.

모델 오버피팅과 람다:

- 과적합 상황: 모델이 훈련 데이터에 너무 잘 맞춰져 있어서, 새로운 데이터나 테스트 데이터에서는 성능이 좋지 않은 상태입니다. 이 경우 람다 값을 증가시켜 모델의 복잡성을 줄이고, 필요 이상의 데이터 패턴 학습을 억제함으로써 오버피팅을 감소시킬 수 있습니다.

- 람다 선택: 람다의 최적값은 보통 교차 검증을 통해 결정됩니다. 교차 검증을 통해 여러 람다 값에 대한 모델의 성능을 평가하고, 가장 좋은 일반화 성능을 보이는 람다 값을 선택합니다.

람다와 같은 정규화 매개변수의 적절한 설정은 딥 러닝 모델을 포함한 여러 머신 러닝 모델에서 중요한 요소입니다. 이는 모델이 복잡한 데이터에서 유의미한 패턴만을 학습하도록 도와주며, 장기적으로는 더 강건하고 신뢰할 수 있는 예측 모델을 구축하는 데 기여합니다.

Q. 람다가 커지면?

A. 람다(λ)가 커지면 모델의 복잡성을 줄이는 효과가 있어서, 모델은 더 단순해지고 결과적으로 거의 선형적인 형태를 띨 수 있습니다. 이는 모델이 과적합을 피하고 일반화 성능을 높이는 데 도움을 줍니다.

람다가 높은 값으로 설정되면, 정규화 항의 영향이 커져 모델 파라미터들이 0에 가까워지도록 만듭니다. 이는 모델이 더 많은 데이터 패턴을 무시하고 가장 중요한 특성만을 사용하여 결정을 내리게 만듭니다. 결과적으로 모델의 결정 경계가 더욱 단순하고 부드러워지며, 선형 회귀식처럼 간단한 형태로 나타날 수 있습니다.

Q. 람다가 작아지면?

람다(λ)가 작아지면 정규화의 영향이 감소합니다. 이는 모델이 훈련 데이터에 더 잘 맞추려고 시도하게 되며, 이로 인해 모델의 복잡성이 증가하고 더 많은 데이터의 세부적인 패턴과 노이즈까지 학습할 수 있습니다. 즉, 람다가 낮을수록 모델이 과적합(overfitting)될 가능성이 높아집니다.

과적합이 발생하면 모델은 훈련 데이터에는 매우 높은 정확도를 보이지만, 새로운 데이터나 테스트 데이터에 대해서는 일반화 성능이 떨어질 수 있습니다. 모델이 훈련 데이터의 무작위 노이즈나 비현실적인 데이터 특성까지 학습하기 때문에, 실제 운영 환경에서 예측력이 저하될 위험이 커집니다.

따라서 람다를 설정할 때는 모델의 복잡성과 일반화 능력 사이의 균형을 잘 맞추는 것이 중요합니다. 람다를 너무 낮게 설정하면 과적합 위험이 있고, 너무 높게 설정하면 모델이 너무 단순해져 훈련 데이터에서조차 충분히 좋은 성능을 내지 못할 수 있습니다.

해결책 3: 데이터 증강(Data augmentation)

"데이터 증강(Data augmentation)"은 모델의 과적합을 방지하고 일반화 성능을 향상시키기 위해 사용되는 기법입니다. 이 방법은 기존 훈련 데이터에 약간의 변형을 주거나 잡음을 추가하여 데이터의 양을 인위적으로 늘리는 방식으로, 모델이 더 다양하고 광범위한 데이터 패턴을 학습할 수 있도록 돕습니다.

데이터 증강의 주요 목적과 방법

- 강건성 향상(Robustness): 데이터 증강을 통해 모델은 더 다양한 형태의 데이터에 대해 견고하게 반응할 수 있습니다. 예를 들어, 이미지 데이터의 경우 회전, 크기 조정, 색상 변조 등을 적용하고, 텍스트 데이터의 경우 문장의 단어를 재배열하거나 동의어를 사용하는 등의 방법이 있습니다.

- 인공적 데이터 생성: 잡음을 추가하거나 기존 데이터를 변형하여 새로운 데이터를 생성합니다. 이는 특히 레이블된 데이터가 부족한 경우에 유용하며, 모델이 실제 환경에서 발생할 수 있는 예외 상황이나 노이즈에도 견딜 수 있는 능력을 개발하는 데 도움을 줍니다.

- 훈련 효율 개선: 데이터 증강을 통해 생성된 다양한 데이터는 모델이 훈련 과정에서 보다 많은 패턴과 변형을 경험하게 하여, 같은 데이터에 대한 과적합을 줄이고 실제 세계의 다양한 상황에 대해 더 잘 일반화될 수 있도록 합니다.

이처럼 데이터 증강은 모델이 단순히 훈련 데이터에 최적화되는 것을 넘어, 실제 환경에서의 예측 성능을 향상시키기 위한 중요한 전략 중 하나로 활용됩니다.

해결책 4: 데이터 증강(Data augmentation)

멀티태스크 학습(Multitask Learning)은 다양한, 하지만 관련된 여러 학습 과제를 동시에 수행함으로써 전반적인 학습 효율을 향상시키는 기법입니다. 이 접근 방식은 서로 다른 과제들이 일부 파라미터를 공유하도록 함으로써, 각 과제의 성능을 개별적으로 향상시키는 동시에 과적합을 줄이는 데 도움을 줍니다.

멀티태스크 학습의 구조 및 특징

- 공유 파라미터(Shared Parameters): 여러 과제들이 기본적인 특징들을 공유하며, 이러한 공유를 통해 모델은 각각의 과제에서 필요한 일반적인 지식을 추출하고 효율적으로 학습할 수 있습니다.

- 과제 특정 파라미터(Task-specific Parameters): 각 과제의 독특한 요구사항을 충족시키기 위해 특정 과제만을 위한 파라미터를 추가로 학습합니다. 이는 공통적인 특징을 학습하는 동시에 각 과제의 특별한 필요를 만족시키기 위한 것입니다.

- 일반적인 파라미터(Generic Parameters): 모든 과제에 걸쳐서 일반적으로 사용되는 파라미터를 말합니다. 이들은 기본적인 데이터 표현 방식을 학습하고 여러 과제에 걸쳐 재사용될 수 있는 핵심 요소들을 포함합니다.

멀티태스크 학습의 장점

- 학습 효율 향상: 공유 파라미터를 통해 다양한 과제에서 얻은 지식을 서로 공유함으로써 학습 과정이 더욱 효율적이 됩니다.

- 과적합 감소: 여러 과제를 동시에 학습함으로써 각 과제에 대해 과도하게 특화된 모델이 되는 것을 방지하고, 더 일반화된 모델을 개발할 수 있습니다.

- 추론 능력 강화: 서로 다른 과제를 통해 얻은 지식과 통찰력이 각 과제의 문제 해결에 기여하여 모델의 전체적인 추론 능력과 적응성을 높일 수 있습니다.

멀티태스크 학습은 특히 관련된 여러 과제가 있고, 각각의 데이터셋이 비교적 작을 때 유용하게 사용될 수 있으며, 과제 간의 연관성이 클수록 더 큰 효과를 발휘합니다.

해결책 5: 파라미터 타이잉(Parameter Tying)

파라미터 타이잉(Parameter Tying)은 다양한 문제, 예를 들어 A와 B에서, 모델의 일부 파라미터를 강제로 공유하게 만드는 방식입니다. 이 방법은 서로 다른 모델이나 네트워크 부분에서 같은 파라미터 값을 사용하도록 하여, 모델의 자유도를 줄이고 과적합을 방지하는 데 도움을 줍니다.

Critical Issue 3: Optimization

일반 최적화 문제점

- 효율성 증가와 정확도 감소 간의 트레이드오프가 존재합니다. 효율을 높이려 할 때 종종 정확도가 감소할 수 있습니다.(속도를 높인다는 것은 데이터를 한번이라도 더 학습하자를 의미 → 수렴 → 정확하도록 노력)

딥러닝 최적화

- 딥러닝에서는 효율성이 증가함에 따라 더 많은 학습 에포크가 필요하며, 이는 정확도를 증가시킬 수 있습니다.

Remedy 1: Stochastic Gradient Descent (SGD) with Minibatch

- 온라인 학습: 단일 데이터 포인트에 대해 가중치를 업데이트합니다.

- 배치 학습: 전체 데이터셋에 대해 가중치를 업데이트합니다.

- 미니배치: 소규모 데이터로 구성된 샘플 배치입니다. (배치를 다 보면 시간이 오래 걸리므로, 랜덤으로 조금만 보자)

- SGD: 미니배치에 대해 가중치를 업데이트하여 더 빠른 수렴과 더 나은 일반화를 가능하게 합니다.

Remedy 2: Momentum (현재 그래디언트+과거 그래디언트)

- 가중치 업데이트는 현재 그래디언트와 과거 그래디언트의 합으로 이루어집니다.

- 모멘텀은 그래디언트의 변화량에 영향을 주어 더 빠른 수렴을 도모합니다.

Remedy 3: Adaptive Learning Rate

- 큰 그래디언트: 작은 학습률을 사용하여 업데이트 크기를 조절합니다. (small learning rate) → 그래디언트가 크면 많이 틀리는 구간이라고 생각하여 보폭을 줄여(러닝레이트 작게하여) 꼼꼼하게 봄

- 작은 그래디언트: 큰 학습률을 사용하여 보다 빠른 학습을 촉진합니다. (large learning rate) → 그래디언트가 작으면 많이 아는 부분이네 라고 인식을 하고 러닝레이트 크게하여 쓰윽 보고 지나감

- Adam Optimizer: 적응형 학습률(Adaptive Learning Rate)과 모멘텀을 결합하여 더욱 효율적인 학습을 지원합니다.

→ 이 옵티마이저가 기존의 배치 옵티마이저를 계산한 세가지 아이디어를 쓰고 각각 알고리즘에 어떻게 되어있는지 쓰시오.

- 큰 그래디언트에 대한 작은 학습률 (Adaptive Learning Rates for Large Gradients):

- Adam은 큰 그래디언트를 가진 매개변수의 업데이트 크기를 조절하기 위해 작은 학습률을 사용합니다. 이는 더 안정적인 학습을 보장하며, 학습 중 큰 변경이 필요하지 않은 영역에서 모델이 너무 멀리 벗어나지 않도록 합니다.

- 작은 그래디언트에 대한 큰 학습률 (Larger Learning Rates for Small Gradients):

- 그래디언트가 작은 경우, 즉 모델이 이미 올바른 방향으로 잘 조정되어 있거나 최적점에 가까운 경우, Adam은 보다 큰 학습률을 적용하여 빠른 학습을 촉진합니다. 이는 보다 빠른 수렴에 도움을 줄 수 있습니다.

- Adam Optimizer의 적응형 학습률과 모멘텀 (Adaptive Learning Rate and Momentum of the Adam Optimizer):

- Adam 알고리즘은 각 매개변수의 업데이트에 적응형 학습률을 사용하며, 이는 과거 그래디언트의 지수 감쇠 평균을 활용합니다. 또한 모멘텀을 사용하여 과거 방향의 그래디언트를 고려함으로써, 학습 과정을 가속화하고 보다 안정적으로 최적점을 찾을 수 있도록 합니다.

Remedy 4: Batch Normalization

- 숨겨진 유닛들의 정규화를 통해 학습 과정에서의 내부 공변량 변화 문제를 줄입니다. 이는 각 레이어에서 입력 분포가 학습 과정에서 일정하게 유지되도록 돕습니다.

전반적인 딥러닝 네트워크에 대한 설명

- 다층 퍼셉트론(MLP)에 두 개 이상의 숨겨진 레이어가 있는 구조를 깊은 전방향 신경망 또는 완전 연결 네트워크라고 부릅니다.

- 레이어 수가 증가함에 따라 일부 수학적 해결책이 필요하며, 특정 유형의 문제를 해결하기 위해 다른 네트워크 구조가 존재합니다.

[참고자료: GPT..]

'Deep Learning' 카테고리의 다른 글

| "7wk_Convolutional Neural Networks(구조 파악) (0) | 2024.04.21 |

|---|---|

| 7wk_Convolutional Operation for Multi-channel Inputs (0) | 2024.04.20 |

| 4wk_Neural Networks (0) | 2024.03.30 |

| 3wk_Machine Learning Basic (0) | 2024.03.23 |

| 2wk_Deep learning (0) | 2024.03.16 |